이번에 리뷰할 논문은 이미지 분류를 위하여 ResNet에 Inception architecture를 적용하여

더 적은 자원으로 효율적인 모델을 만든 ResNext이다

Prior work and difference

논문의 도입부에서는 Vison task에서 특성 엔지니어링이 아닌 네트워크 엔지니어링이 추세가 되고 있다고 말합니다.

하지만 조정해야할 하이퍼 파라미터의 증가로 인해 네트워크 구조를 디자인하는 것에 어려움이 있습니다.

논문에서는 기존의 Vision모델들을 두가지 분류로 나누어 비교합니다

- VGGNet, ResNet과 같이 똑같은 파라미터를 가진 topology(layer 연결 구조)를 사용해 setting할 hyper parameter를 줄이고 데이터에 과적합은 막는 분류

- Inception과 이에서 파생된 모델들과 같이 hyper parameter setting에 노력을 들여 특정 데이터에서 높은 성능을 보여주는 분류

저자는 논문에서 제안하는 모델이 Inception의 split-transform-merge전략에 각각의 모듈을

기존의 모델들처럼 same topology를 적용하여 setting할 parameter를 줄이고 일정 성능을 얻을 수 있다고 합니다.

Cardinality

저자는 효율이 높은 네트워크 구조 설계를 쉽게 찾기 위한 구조를 찾는게 목적이라고 논문에서 계속해서 강조했습니다. 이를 위해 사용된 새로운 파라미터가 Cardinality이다.

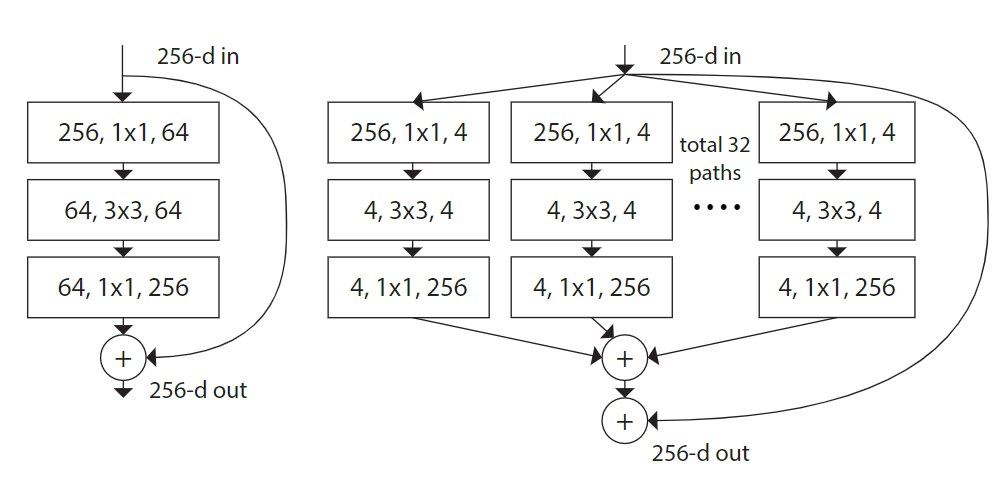

위 그림에서 왼쪽이 ResNet의 병목 구조이며 오른쪽은 ResNext의 모듈이다. ResNext는 채널 수를 줄이고 이를 병렬적으로 나열하였는데 나열한 모듈의 개수를 Cardinality라고 이름 지었다.

추가적으로 나열한 모듈은 모두 같은 구조를 가지고 있어 Inception과 달리 네트워크 구조를 fine tuning할 필요가 없다. 논문에서는 이를 same topology를 가진다고 표현하였다.

Model capacity

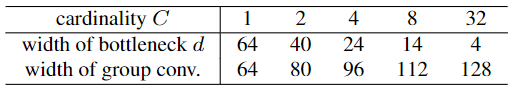

ResNet과 ResNext의 성능 비교를 위하여 두 모델의 parameter를 비슷하게 유지하였다.

Cardinality의 변화에 따라 같은 연산량을 유지하기 위하여 병목층에 입력되는 d를 조절하며 실험을 진행하였다.

아래의 그림에서 오른쪽 모델은 d=4, C(Cardinality)=32 로 설정한 ResNext이며 연산량은 ResNet과 차이가 크지 않다.

Results

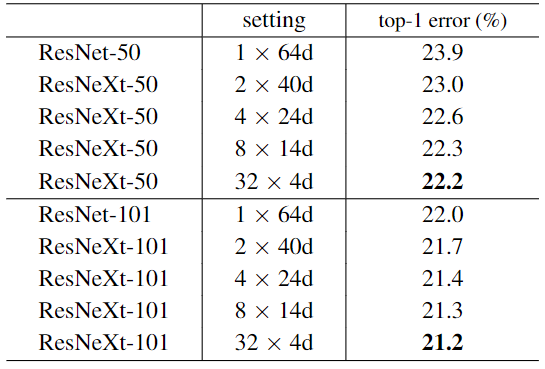

parameter를 거의 동일하게 설정하고 실험을 진행하였을 때 ResNext의 성능이 ResNet보다 높았다.

또한 Cardinality를 높일 때마다 성능이 증가하는 경향을 보였다.

이후 내용으로는 추가적으로 Width와 Cardinality 그리고 with shortcut, without shortcut등의 ablation study와

다른 데이터셋에 대한 실험이 진행되나 결론은 전부 위와 유사하여 생략하였다.

Insights

2010년도에 나온 기존 모델의 연산량을 유지하며 높은 성능을 내는 새로운 아키텍쳐 구조를 제안하는 논문 중 하나이다.

Inception과 유사해 보이지만 크게 두 가지면에서 기존의 모델의 차이점을 보인다고 생각한다.

1. same topology를 사용하여 parameter를 Cardnality하나로 통합함

따라서 최적화된 network architecture를 찾기 위한 노력을 줄일 수 있음

2. Inception과 같은 병렬적으로 학습하는 모델 구조의 높은 효율성을 입증

ResNext 논문 링크:https://arxiv.org/abs/1611.05431